Ein Hauptziel der Klimawissenschaften heute ist, die Folgen des menschengemachten Klimawandels genau vorherzusagen. Hier stellt sich zum Beispiel die Frage, wie stark der Meeresspiegel steigen wird oder welche Regionen mit mehr Trockenheiten oder Starkregen rechnen müssen. Globale Klimamodelle sind das wichtigste Werkzeug, um solche Vorhersagen zu treffen. Klassische Klimamodelle berechnen die physikalischen und chemischen Prozesse der Atmosphäre und der Ozeane unter Berücksichtigung der Sonneneinstrahlung und verschiedener Szenarien der CO2-Konzentration. In jedem Zeitschritt wird eine Vielzahl von Variablen wie Temperatur, Luftfeuchtigkeit und Druck für die gesamte Atmosphäre und die Meere simuliert.

Um die Gleichungen, die physikalische Gesetzmäßigkeiten wie Energie- und Drehimpulserhaltung beschreiben, zu lösen, wird die Erde in einem 3D-Gitter abgebildet. Das heißt, die Erdoberfläche und Atmosphäre werden in viele kleine Gitterboxen aufgeteilt, sodass die einzelnen Variablen in jeder Gitterbox durch einen Wert beschrieben werden können. Dabei führt eine höhere Auflösung – also eine feinere Gitterstruktur – zu genaueren Simulationen. Allerdings erfordern feinere Auflösungen mehr Rechenleistung und Zeit, und selbst die leistungsstärksten Supercomputer können nicht jedes Detail des Erdsystems abbilden. Beispielsweise hat CESM2, aktuell eines der besten globalen Klimamodelle, Gitterboxen der Größe 100 x 100 Kilometer und braucht ungefähr 144

Modelle wie das CESM2 können die globale Durchschnittstemperatur auch bis Ende des Jahrhunderts gut abschätzen, doch ihre regionalen Niederschlagsprognosen sind mit hohen Unsicherheiten verbunden. Dies liegt daran, dass kritische Ereignisse wie Wolkenbildung, Regen oder Stürme sich meist nur auf kleinen Skalen von wenigen Kilometern abspielen und in den Modellen mit viel größeren Gitterboxen deswegen nicht dargestellt werden können.

Trotzdem haben diese kleinskaligen Wetterereignisse einen großen Einfluss auf die langfristigen Trends des globalen Klimas. Wolkenbildung zum Beispiel hat einen lokal abkühlenden Effekt auf die Temperatur, da Wolken die Sonneneinstrahlung reflektieren. In dem chaotischen System Atmosphäre kann diese lokale Abkühlung zu Änderungen in benachbarten Regionen führen, die, wenn groß genug, zur Veränderung des Energiebudgets auf großen Skalen führen. Um diese Effekte zu berücksichtigen, müssen die kleinskaligen Prozesse innerhalb jeder Gitterbox abgeschätzt werden, ein Vorgang, den man „Parametrisierung“ nennt. Bisher basieren solche Parametrisierungen meist auf vereinfachten Gleichungen, die annähernd beschreiben, wie kleinskalige Wetterereignisse langfristige klimatische Bedingungen einer Gitterbox beeinflussen. Diese Gleichungen sind jedoch oft ungenau und mit Fehlern behaftet. Stefan Rasp und sein Team schlagen vor, die Parametrisierung von Klimamodellen mit

Um ihre Idee zu demonstrieren, verwenden die Autoren ein vereinfachtes globales Klimamodell mit Gitterboxen der Größe 200 x 200 Kilometer. Aufgrund der groben Auflösung des Klimamodells muss der Einfluss der Wolkenbildung parametrisiert werden. In der Studie werden die klassische Wolkenparametrisierung und die Parametrisierung mit einem neuronalen Netz verglichen. Das neuronale Netz wird mit Daten aus einem hochauflösenden Cloud Resolving Model (CRM) trainiert. Das CRM simuliert kleinskalige Prozesse wie Wolkenbildung und Turbulenzen explizit, ist jedoch aufgrund seiner Rechenintensität nicht für langfristige Klimaprognosen geeignet. Im Trainingsprozess erhält das neuronale Netz Datenpaare: einerseits die Variablen des grob aufgelösten Klimamodells und andererseits die korrespondierenden, über die Gitterboxen gemittelten Variablen des CRM. Wie in der klassischen Parametrisierung korrigiert das neuronale Netz damit die Variablen des globalen Klimamodells in jeder Gitterbox. Diese Korrektur spiegelt feinskalige Prozesse wider, da das Netzwerk auf CRM-Daten basiert.

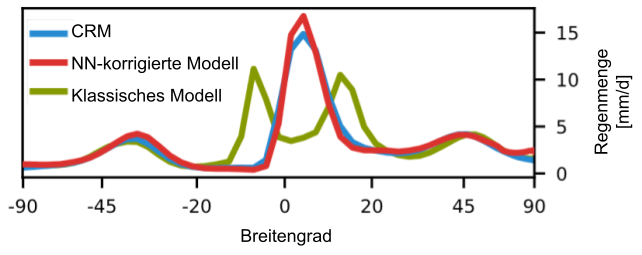

Die Forscher zeigen, dass das neuronale Netzwerk typische Fehler der klassischen Parametrisierung behebt. Das Klimamodell mit klassischer Parametrisierung zeigt zum Beispiel übermäßig häufigen Nieselregen und zu wenig Starkregenereignisse, die durch das neuronale Netz korrigiert werden. Trotz der groben Auflösung spiegelt das mit dem neuronalen Netz (NN, siehe Abbildung) korrigierte Klimamodell die Eigenschaften des feinskaligen CRM wider. Außerdem ist es deutlich schneller: Es benötigt 95 Prozent weniger Rechenzeit, da es nicht wie das CRM eine numerische Integration über viele kleine Zeitschritte berechnet, sondern nur eine einmalige Berechnung erfordert.

Nach diesen vielversprechenden ersten Ergebnissen testeten die Autoren ihr Modell noch auf seine physikalische Richtigkeit. In allen physikalischen Systemen müssen nach den Gesetzen der Mechanik Energie- und Drehimpulserhaltung gelten – alle korrekten Klimavorhersagen müssen daher diese „Regeln“ einhalten. Obwohl das neuronale Netz nie explizit etwas über physikalische Gesetzmäßigkeiten gelernt hat, erfüllt das NN-korrigierte Modell diese Vorgaben. Dies ist wahrscheinlich auf das Training mit den simulierten CRM-Daten zurückzuführen, in denen Energie- und Drehimpulserhaltung gilt, sodass das neuronale Netz diese Zusammenhänge indirekt lernen konnte. Dieser Transfer klappte allerdings nicht immer: Bei der Betrachtung wärmerer Klimaszenarien offenbarte das NN-korrigierte Modell nämlich Fehler. Da die Dynamiken der Atmosphäre sich bei höheren Temperaturen verändern, hat das neuronale Netz nie vergleichbare Daten während des Trainings gesehen. Solche neuen Daten, die sich stark von den Trainingsdaten unterscheiden, nennt man Out-of-distribution (OOD). An ihnen scheitern neuronale Netze generell. Die Lösung: Die Autoren erweiterten das Training mit Daten des CRM, die eine um vier Grad Celsius höhere Temperatur simulieren. Mit dem neu trainierten neuronalen Netz werden korrekte Vorhersagen sowohl für das ursprüngliche Klima als auch für das wärmere Klima getroffen.

Die Integration von neuronalen Netzen in Klimamodelle ermöglicht es Forschenden, die Genauigkeit von Klimavorhersagen zu verbessern. Insbesondere Starkregenereignisse, die durch den menschengemachten Klimawandel immer häufiger auftreten, können mithilfe dieses Ansatzes besser prognostiziert werden. Dank der höheren Effizienz neuronaler Netze im Vergleich zu hochaufgelösten Modellen können Wissenschaftler*innen Klimavorhersagen bis Ende des Jahrhunderts treffen – mit einer Genauigkeit, die bisher nicht möglich war.

In Zukunft werden Hybride aus klassischen Klimamodellen und KI-Modellen eine neue Generation von Klimamodellen hervorbringen, die Ungenauigkeiten der bisherigen Klimamodelle beheben. Ein Problem dieser Hybridmodelle ist jedoch, dass eine fehlerhafte Korrektur des KI-Models zu Instabilitäten im Klimamodell führen kann. Ein minimaler Fehler der KI kann zum Beispiel durch die Interaktion mit dem Klimamodell zu einem selbstverstärkenden Effekt führen, der zu unsinnigen Vorhersagen führt. Einige seit 2021 erschienene Weiterentwicklungen der Studie zeigen jedoch schon, wie dieses Problem angegangen werden kann.