Zu Beginn ein kleines Spiel: Ich zeige euch ein Bild und ihr sagt mir jeweils in einem Wort, was darauf abgebildet ist. Bereit? Also los. Was zeigen die folgenden vier Bilder?

Hier die Auflösung (von links nach rechts): Milbe, Containerschiff, Motorroller, Leopard.

In der Fachsprache der Bildverarbeitung heißt dieses Spiel Bildklassifizierung. Es wird exzessiv gespielt, um Algorithmen das Sehen beizubringen. Eine Aufgabe, deren Komplexität in der Forschung zur künstlichen Intelligenz seit jeher unterschätzt wurde.

Die Bildklassifizierung galt in der Informatik über lange Zeit als heiliger Gral. So wundert es nicht, für welchen Wirbel die Arbeit von drei Computer-Vision-Forschenden an der Universität von Toronto im Dezember 2012 sorgte. Doch eigentlich basierte der Durchbruch auf 23, wenn nicht sogar 32 Jahre alten Erkenntnissen. Aber eins nach dem anderen.

Bei der Bildverarbeitung suchten die Forschenden zunächst Inspiration im Aufbau und in der Funktionsweise des menschlichen Gehirns. Der Fokus lag dabei auf dem hierarchisch organisierten

Traditionelle Ansätze zur Bildklassifizierung basierten also auf Detektoren, die von Experten entwickelt wurden. Sie reagierten auf verschiedene Merkmale in Bildern, wie Linien, Farben oder Kreise. Auf Basis dieser Detektoren wurden anschließend

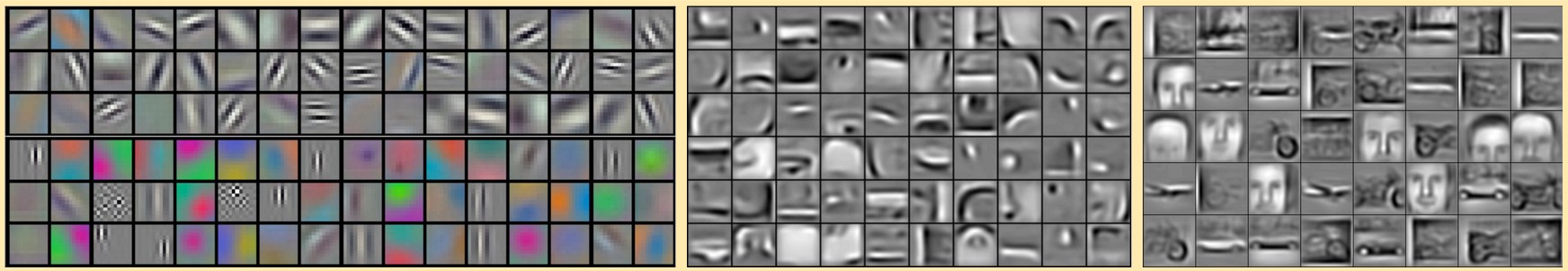

AlexNet erlernte kurzerhand eine Vielzahl von Kanten-, Farb- und Kreisdetektoren in unterschiedlichsten Variationen (abgebildet in der folgenden Grafik). Es lernte, diese beliebig zu kombinieren, bis zuletzt immer komplexere und alltagsnähere Gegenstandsdetektoren herausgebildet wurden.

In der Grafik stellt jedes schwarz eingerahmte Panel einen von dem künstlichen neuronalen Netzwerk selbst erlernten Filter dar. Der Filter in der Ecke links oben sucht beispielsweise in jedem Bild nach Kanten, die von links unten nach rechts oben verlaufen. Die bunten Filter sprechen hingegen auf entsprechend farbige Bereiche im Bild an. Durch die Kombination eines Kantenfilters mit einem Farbfilter kann etwa eine grüne Kante in der entsprechenden Orientierung detektiert werden. Die Bildergruppe in der Mitte zeigt bereits selbst erlernte Kombinationen der Filter im linken Bild. Darauf lassen sich mit etwas Fantasie schon Augen-, Nasen-, oder Reifendetektoren erkennen. Die Panele des rechten Bildes zeigen schließlich die abstraktesten Filter. Diese hat das Netzwerk wieder durch Kombination vieler vorheriger Filter gelernt. Je nach Aufgabe des künstlichen neuronalen Netzwerks lernt es unterschiedliche Bilder. In diesem Fall wurde das Netz vermutlich darauf trainiert, Autos, Flugzeuge und Gesichter zu erkennen.

Während 2012 der bis dahin beste Ansatz zur Bildklassifizierung in 52,9 Prozent der Fälle richtig lag, erzielte AlexNet eine Trefferquote von 62,5 Prozent. Ein Quantensprung für die damaligen Verhältnisse. Zum Vergleich: Ein Mensch erkannte das richtige Objekt mit einer Quote von 94.9 Prozent

Der revolutionäre Ansatz von Alex Krizhevsky beruhte auf dem Prinzip des

Die scheinbar banale Fähigkeit, Objekte auf Bildern zu erkennen, hat die Wissenschaft wesentlich länger beschäftigt, als ursprünglich erwartet. Für den Durchbruch sorgte schließlich die effiziente Implementierung eines Algorithmus aus dem 20. Jahrhundert auf moderner Hardware. Die Hürden, Computern das Sehen beizubringen, waren also praktischer und weniger konzeptueller Natur. Heute ist das Prinzip des CNN und der parallelen Berechnung von selbsterlernten Detektoren tief in sämtlichen Algorithmen zur Bildverarbeitung verwurzelt und kommt auch in mobilen Endgeräten zur alltäglichen Anwendung.