Angenommen wir haben ein kompliziertes

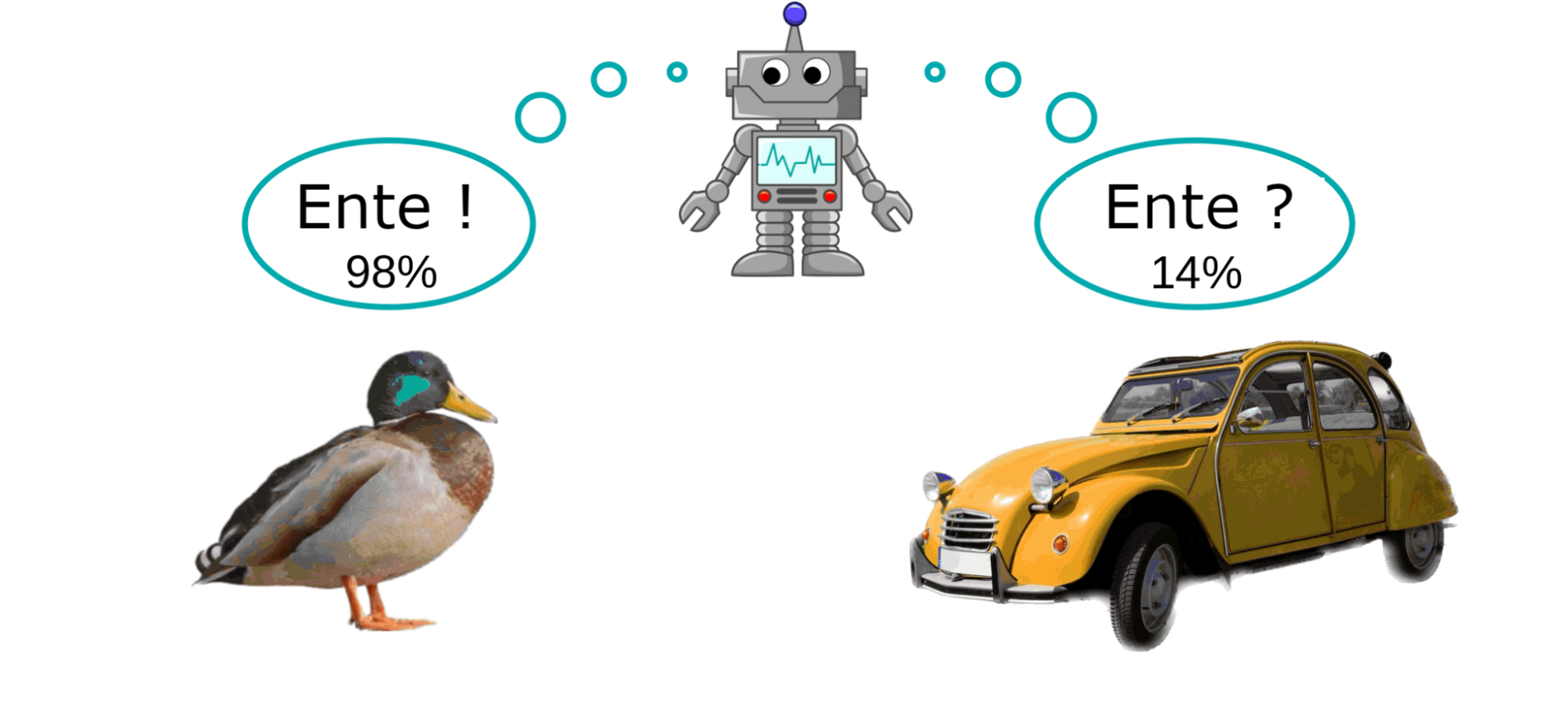

In der Praxis reicht es uns aber nicht, dass unser Modell eine bestimmte Tierklasse als Antwort gibt. Es soll uns mitteilen, wie sicher es sich bei seiner Zuordnung ist. Wir wollen, dass sich das Modell, das wir auf Tierbildern trainiert haben, besonders unsicher ist bei der Frage: „Welches Tier ist eine VW-Ente?“ Es soll merken, dass es sich hierbei um kein Tier handelt.

Das ist noch lange nicht alles. Unser Modell soll außerdem auf eine gewisse Art robust sein: Für zwei sehr ähnliche Bilder soll es die gleiche Antwort geben. Das bedeutet, kleine Änderungen im Bild, wie Schatten, Unschärfe oder Rauschen, sollen seine Antwort nicht beeinflussen. Es soll sich auch bei dieser Antwort ähnlich sicher beziehungsweise unsicher sein.

Für einige dieser Anforderungen gibt es bereits zufriedenstellende Lösungen. Viele Modelle klassifizieren Bilder besser, als es Menschen können. Es gibt einerseits Modelle, die robust gegen subtile oder für den Menschen unmerkliche Veränderungen etwa im Hintergrund des Bildes sind, und andererseits Modelle, die zuverlässig wissen, wenn sie die Antwort nicht wissen. Alles gleichzeitig zu können, erweist sich aber als Herausforderung. Oft sind Modelle wenig robust oder übertrieben selbstsicher bei der Zuordnung von Bildern, die sie eigentlich nicht erkennen können.

In ihrem Paper verbinden Meinke, Bitterwolf und Hein bereits bestehende Ansätze zu robusten Modellen. Sie entwickeln eine Lernmethode, mit der ein Modell zuverlässig lernt, unsicher zu sein bei Bildern von Dingen, die es nicht kennen kann, und robust richtige Antworten zu geben bei Bildern, auf die es trainiert wurde. Wenn wir unser Modell nach dieser Methode trainieren, dann klassifiziert es also zuverlässig Tierbilder und sagt uns, dass es unsicher ist, wenn wir ihm ein Foto von einem Auto zeigen.

Aber woher wissen wir, dass unser Modell wirklich weiß, wenn es überfragt ist, und nicht bei einem Foto von einem Haus antwortet, dass es sich um eine Schildkröte handelt? Meinke und Kollegen konstruieren ein Modell, das beweisbar, robust und zuverlässig ist. Zudem adaptieren sie dessen Architektur so, dass die für

Transparenzhinweis: Das hier vorgestellte Paper entstand an der Universität Tübingen.