Inzwischen gibt es viele Ansätze zur Erklärung von Black-Box-Modellen. Je nach Anwendung kommen unterschiedliche Erklärungen in Frage, die sich in unterschiedliche Bereiche aufteilen lassen.

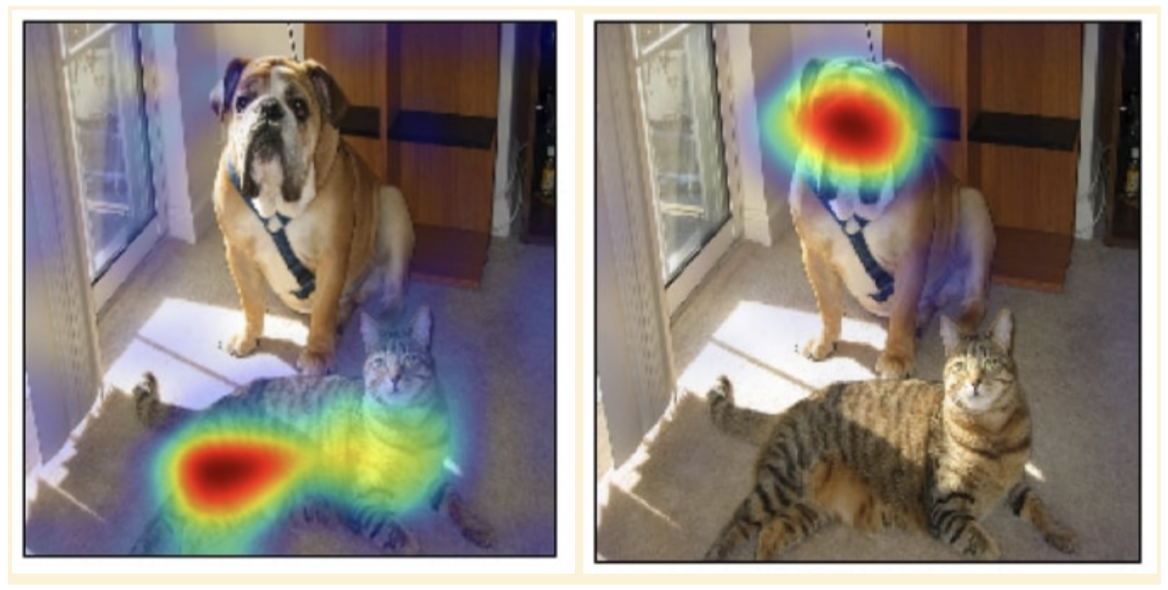

Feature Attribution Methods ordnen den

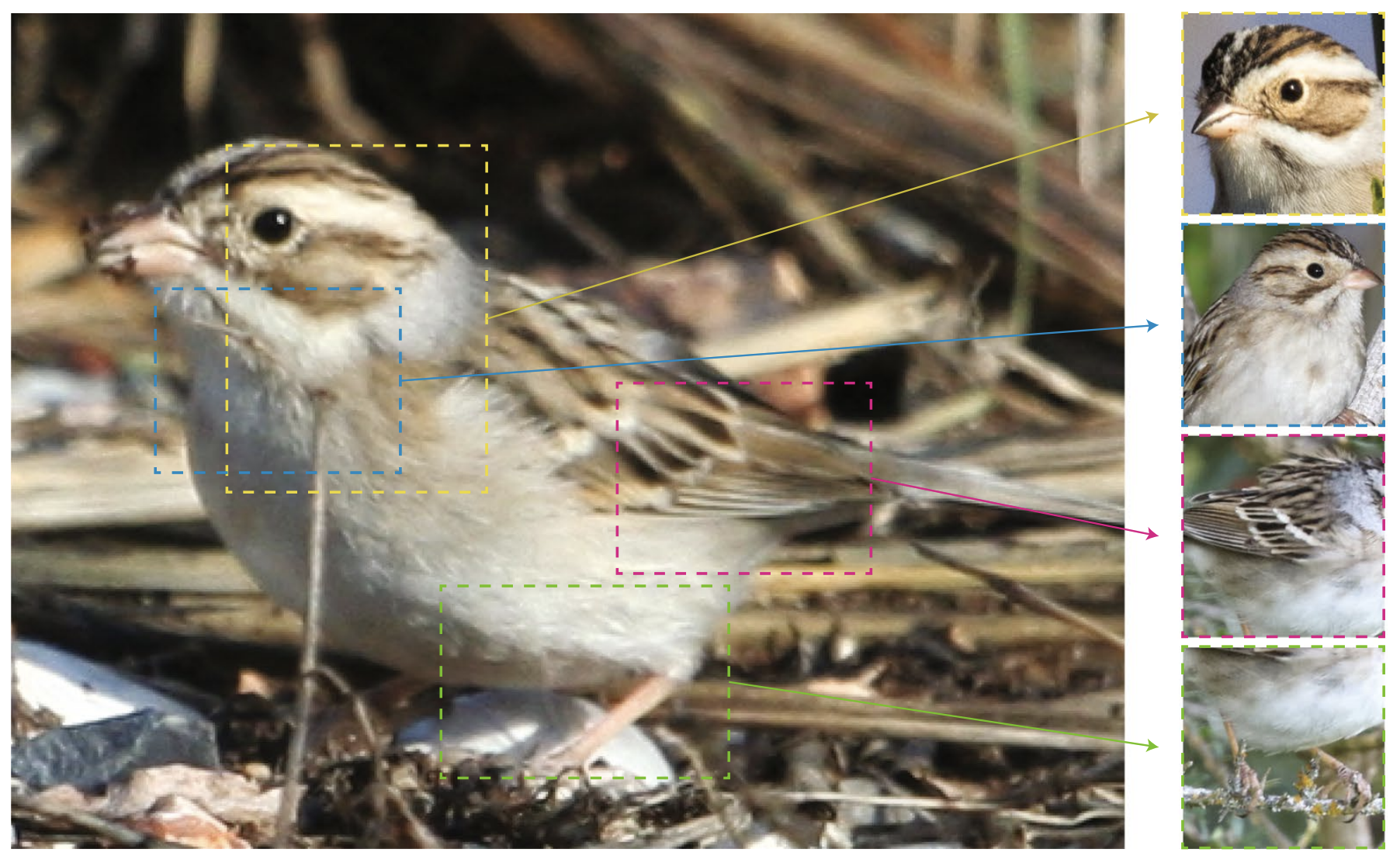

Eine weitere Methode zur Erklärung von Black-Box-Modellen setzt bei den verfügbaren

Manche Erklärungsansätze haben nicht primär das Ziel, ein Black-Box-Modell zu entschlüsseln, sondern zu ermitteln, welche Faktoren geändert werden müssten, damit das gewünschte Ergebnis erzielt werden kann. Wenn eine Person zum Beispiel einen Kredit nicht bekommt, beantworten sogenannte counterfactual explanations, also kontrafaktische Erklärungen, die Frage, was sich ändern müsste, damit sie den Kredit erhalten würde. Hierbei werden ihre Eingabe-Attribute so verändert, dass das Modell dem neu entstandenen

Neben Erklärungen für Black-Box-Modelle gibt es zudem Modelle, die per se

Cynthia Rudin vertritt in ihrem Paper aus dem Jahr 2019 die These, dass solche interpretierbaren Modelle nicht im Gegensatz zu Black-Box-Modellen stehen müssen: Es kann Modelle geben, die sehr akkurat sind, das heißt meistens richtig liegen, aber anders als Black-Box-Modelle auch interpretierbar sind. Damit widerspricht sie der in der Forschung sehr häufig vertretenen These, dass ein akkurates Modell sehr komplexe Entscheidungsregeln lernen muss und somit nicht interpretierbar sein kann.

Rudin zeigt auf, dass gerade in Bereichen der Datenanalyse interpretierbare Modelle helfen könnten, Daten besser zu verstehen. Das wiederum würde zur Entwicklung genauerer Modelle beitragen, da auf Basis dieses Verständnisses besser entschieden werden könnte, welche Datenbestände sich für welche Anwendungen eignen.

Sie kritisiert, dass durch den Irrglauben, interpretierbare Modelle seien nicht akkurat, zu wenig zu ihnen geforscht werde: Viele interpretierbare Modelle seien veraltet und die Entwicklung fokussiere sich zu stark auf Black-Box-Modelle. Es sei also nicht verwunderlich, dass die neueren Black-Box-Modelle häufig bessere Ergebnisse erzielten als interpretierbare Modelle. Der Vergleich zwischen einem im Jahr 1984 entwickelten interpretierbaren Modell und einem Black-Box-Modell von 2018 sei irreführend.

Ein Faktor, der einen Fortschritt in der Entwicklung von interpretierbaren Modellen bremse, sei zudem, dass sie oft nur anwendungsspezifisch mit Hilfe von Expertenwissen möglich sei. Um zum Beispiel auf medizinischen Daten basierend ein zugleich akkurates und interpretierbares Modell zu entwickeln, ist die Meinung eines Mediziners unerlässlich: Nur er kann beurteilen, welche Entscheidungsregeln, auf denen ein Modell basiert, medizinisch gesehen Sinn macht. Das macht den Prozess aufwändig, zeitintensiv und in vielen Fällen auch teuer. Man sollte jedoch hinterfragen, ob die Entwicklung eines solchen Modells ohne die medizinische Expertise überhaupt sinnvoll und die Anwendung von Black-Box-Modellen in solchen hochriskanten Fragen tragbar ist.

Rudin sieht die Notwendigkeit einer verantwortungsvollen Regulierung von Black-Box-Modellen und verweist auf die im Jahr 2018 in Kraft getretene Datenschutzgrundverordnung (DSGVO). Diese enthält Informationspflichten und Auskunftsrechte, die sich auch auf die Erklärung von Black-Box-Modellen beziehen können. Sie weist darauf hin, dass es für die Datenverarbeiter allerdings ein Leichtes sei, die Erklärung eines Modells zu manipulieren: Für jedes Modell könne ein anderes Modell konstruiert werden, das zwar zu demselben Ergebnis gelange, aber aufgrund anderer Entscheidungsregeln. Auf diese Weise könne vertuscht werden, aufgrund welcher Regeln das Modell ursprünglich zu seiner Vorhersage gelangt sei.

Der aktuelle Entwurf des

Cynthia Rudin versucht mit ihrer Arbeit dazu zu motivieren, verstärkt an interpretierbaren Modellen zu forschen und auch die Industrie dazu zu motivieren, sich nicht mit erklärbaren Black-Box-Modellen zufrieden zu geben. Sie drückt ihre Sorge darüber aus, dass Black-Box-Modelle ansonsten weiterhin in solchen sensiblen Bereichen wie beispielsweise der Strafverfolgung oder der Medizin verwendet werden und dort aufgrund ihrer Intransparenz Menschen schaden können.