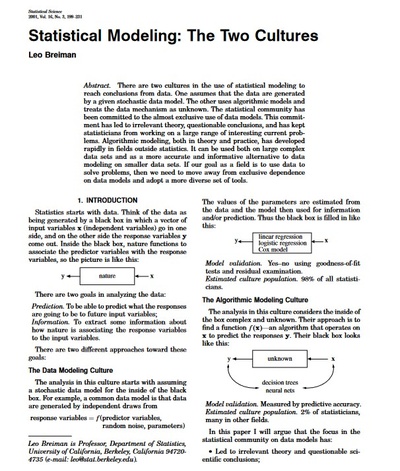

Als Breiman den vorliegenden Essay schreibt, sind die Vorläufer des heutigen maschinellen Lernens noch einfache Modelle aus Statistik und Wahrscheinlichkeitstheorie. Er nennt diese „klassische“ Perspektive Data Modeling Culture.

Doch was bedeutet das praktisch? Ein Beispiel: Wenn wir aus Messdaten wie Temperatur, Wolkendichte und Windstärke die Regenwahrscheinlichkeit vorhersagen möchten, brauchen wir zunächst ein Modell. Dieses bündelt unser Weltwissen über die Physik des Wetters. In der Natur gibt es nämlich einen Zusammenhang zwischen all unseren Messdaten. Diesen Zusammenhang bildet ein mathematisches Modell so genau wie möglich ab. Im Idealfall enthält das Wettermodell dann also eine exakte Beschreibung aller atmosphärischen Phänomene und Faktoren, die zu Regen führen könnten.

Breiman sieht in diesem Data-Modeling-Verfahren einige Vorteile. Unser beispielhaftes Wettermodell lässt sich nämlich nicht nur zur Regenvorhersage nutzen – zusätzlich können Meteorolog*innen mithilfe des Modells besser verstehen, wie genau einzelne Wetterphänomene zusammenwirken, oder die Auswirkungen von Extremwetter-Szenarien simulieren. Außerdem ermöglicht die mathematische Beschreibung des Systems, die Korrektheit der Vorhersagen zu garantieren. Das heißt: Man kann sogar mathematisch beweisen, wie gut eine Wettervorhersage sein wird.

Trotz dieser Vorteile kritisiert Breiman den Data-Modeling-Ansatz fundamental: Denn all seine Vorzüge ließen sich nur realisieren, wenn die Modelle auch wirklich korrekt seien. Und da die Welt meist deutlich komplexer sei als die Modelle von Statistiker*innen, könne man davon in der Regel nicht ausgehen. Damit wären aber laut Breiman sowohl die Interpretierbarkeit als auch die mathematisch garantierte Korrektheit dahin.

Breiman wirft der klassischen Statistik außerdem vor, sich zu sehr auf ihre altbekannten Werkzeuge zu beschränken – in seinen eigenen Worten: „Es gibt ein altes Sprichwort: ‚Wenn ein Mann als Werkzeug nur einen Hammer hat, dann sieht jedes Problem wie ein Nagel aus.‘ Das Problem für Statistiker ist, dass in letzter Zeit einige Probleme nicht mehr wie Nägel aussehen.“

Im Kontrast dazu wirbt Breiman für die Kultur des Algorithmic Modeling: Aus seiner Sicht muss man sich nicht damit aufhalten, die Mechanismen der Natur exakt zu verstehen und nachzubauen. Vielmehr sollte man auf flexible Algorithmen setzen, die mit möglichst wenig Annahmen über die Welt möglichst präzise Vorhersagen liefern. Dabei legt Breiman kaum Wert darauf, ob die Algorithmen dafür denselben „Rechenweg“ wie die Natur verwenden – oder ob sie eine völlig andere Lösung finden.

Im Algorithmic Modeling ersetzen wir also beispielsweise alle Regenmechanismen aus unserem Beispiel mit der Black Box des Algorithmus. Damit können wir aus dem Algorithmus nicht ohne Weiteres Neues über die Physik des Regens lernen. Und auch, wie genau der Algorithmus aus Messwerten Regenschauer vorhersagt, entzieht sich unserem Verständnis. Als Praktiker sieht Breiman darin keinen Nachteil, sondern fokussiert sich auf das, was aus seiner Sicht zählt: ob die Vorhersage stimmt. Schließlich interessiert uns in vielen Fällen nicht, welches Zusammenspiel von Wind und Luftdruck an einem bestimmten Tag zu besonders ergiebigen Regenwolken führt, sondern nur, ob wir einen Regenschirm einpacken sollten oder nicht.

Diese von Breiman beworbene „Black Box“-Kultur prägt maschinelles Lernen bis heute. Viele KI-Ingenieur*innen trimmen Algorithmen allein auf beste Leistung. Welche Zusammenhänge in der Welt vorliegen und auf welchen Mechanismen die Vorhersagen beruhen, ist zweitrangig. Doch diese Perspektive ändert sich zunehmend: In immer mehr Anwendungen von künstlicher Intelligenz und maschinellem Lernen sind undurchschaubare Black Boxes nämlich mindestens fragwürdig. Beispielsweise wenn Computerprogramme automatisch über Krebsdiagnosen oder Kreditwürdigkeit entscheiden, aber keine Begründung für ihre Entscheidungen liefern können. Daher braucht es neue Ansätze, die die Black Boxes der KIs öffnen.

te.ma ist seit dem 1. August 2024 inaktiv und befindet sich im Archivmodus. Alle Veröffentlichungen sind weiterhin zugänglich. Der Kommentarbereich ist deaktiviert, Benutzerkonten können nicht mehr erstellt oder aufgerufen werden und unser Newsletter wird nicht mehr aktualisiert.

Webseite des Exzellenclusters Maschinelles Lernen: Neue Perspektiven für die Wissenschaft

Webseite des Exzellenclusters Maschinelles Lernen: Neue Perspektiven für die Wissenschaft

Dieser Artikel entstand in Zusammenarbeit mit dem Exzellenzcluster Machine Learning: New Perspectives for Science der Universität Tübingen.

Der Ursprung der Black-Box-KIs

Artikeldetails

Inhalte

Webseite des Exzellenclusters Maschinelles Lernen: Neue Perspektiven für die Wissenschaft

Webseite des Exzellenclusters Maschinelles Lernen: Neue Perspektiven für die Wissenschaft

Dieser Artikel entstand in Zusammenarbeit mit dem Exzellenzcluster Machine Learning: New Perspectives for Science der Universität Tübingen.

Inhalte

Intro

Geschrieben von

Jan Lause

Bei te.ma veröffentlicht 04.04.2023

te.ma DOI 10.57964/xshf-x085

Moderne Machine-Learning-Algorithmen werden oft als Black Box bezeichnet, weil selbst ihre Entwickler*innen nicht genau nachvollziehen können, warum ein Algorithmus funktioniert. Wie begann die Geschichte dieser Black-Box-Verfahren? 2001 plädiert Leo Breiman in einem kontroversen Essay für diese neue Denkkultur: weg von einfachen, erklärbaren Algorithmen – hin zur leistungsfähigen Black Box.

Fußnoten

1

„There is an old saying ‚If all a man has is a hammer, then every problem looks like a nail.‘ The trouble for statisticians is that recently some of the problems have stopped looking like nails.“

Re-Paper

Der Ursprung der Black-Box-KIs

Verwandte Artikel

Apr 18, 2023

Wissen sie, was sie nicht wissen? Über die (Un-)Zuverlässigkeit …

Weiß ein künstliches neuronales Netz, wann es überfragt ist? Es ist oft sehr selbstsicher in seinen Antworten, selbst wenn es die Frage nicht versteht. Alexander Meinke, Julian Bitterwolf und Matthias Hein versuchen herauszufinden, wie man ihm beibringen kann, zu erkennen, dass es eine Aufgabe nicht lösen kann.

Re-Paper

Alexander Meinke, Julian Bitterwolf, Matthias Hein, 2021

Kuratiert von Solveig Klepper

KI und Nachhaltigkeit

Apr 12, 2023

Die KI-Forschung wurde schon einmal überschätzt

Schon 1965 prophezeite der berühmte Politikwissenschaftler und Organisationsforscher Herbert A. Simon: „Maschinen werden in zwanzig Jahren in der Lage sein, jede Arbeit zu erledigen, die ein Mensch verrichten kann.“ Er unterschätzte ganz offensichtlich die Komplexität der Aufgabe. Larry Hardesty beschreibt in einem ausführlichen Blogpost, wie das Massachusetts Institute of Technology (MIT) 50 Jahre später einen neuen Anlauf nahm: dieses Mal mit vereinten Kräften aus Informatik, Biologie und Psychologie.

Wissen sie, was sie nicht wissen? Über die (Un-)Zuverlässigkeit …

Die KI-Forschung wurde schon einmal überschätzt

Noch keine Kommentare

Um einen Artikel zu kommentieren, auf andere Nutzer einzugehen oder einen eigenen Beitrag zu verfassen, musst du eingeloggt sein. So bleibt unsere Gemeinschaft sicher und aktiv.