Manche Textsorten sind einfach langweilig. Stellenausschreibungen und Arbeitszeugnisse wirken oftmals formelhaft, generisch und wenig individuell, selbst wenn sie von und für interessante Menschen verfasst werden. Was läge da näher, als diese Aufgabe direkt an einen

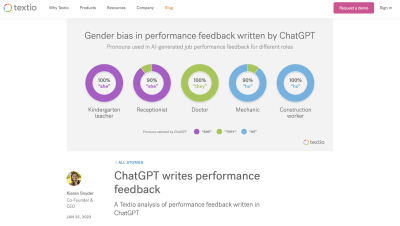

Kieran Snyder hat es sich zur Aufgabe gemacht, versteckte Vorurteile in Texten zu erkennen und zu verhindern, und vermittelt Tools und Strategien dafür an Unternehmen. Sie hat die KI auf ihre Geschlechterstereotypen hin getestet und die Ergebnisse online geteilt.

Welche Pronomen nutzt ChatGPT bei der Aufgabe, Arbeitszeugnisse für Menschen in verschiedenen Berufen zu schreiben, wenn das Geschlecht nicht genannt wird? In Snyders Experiment zeigt sich: Handwerkliche Berufe sind für die KI männlich konnotiert, soziale Berufe eher weiblich. Kindergarten teachers bekommen das Pronomen „she“, construction workers das Pronomen „he“. Zusätzlich wurden Adjektive auf ihre Konnotation bezüglich der Geschlechter getestet: bubbly (lebendig, quirlig) ist für die KI eine eindeutig weibliche Eigenschaft, während den Adjektiven analytical und strong eher das Pronomen „he“ als „she“ zugeordnet wird.

Die englische Sprache bietet jedoch auch die Möglichkeit, das geschlechtsneutrale Pronomen „they“ für eine einzelne Person zu verwenden. ChatGPT tut dies auch, z.B. bei Berufen wie doctor oder lawyer, die anscheinend nicht klar männlich oder weiblich konnotiert sind. Auch das Adjektiv intelligent sieht die KI als geschlechtsneutral an und wählt das Pronomen „they“.

Mit dem Wissen, dass ChatGPT auf Trainingsdaten basiert, die von Menschen geschrieben wurden, sind die Ergebnisse nicht überraschend. Die KI übernimmt unsere Vorurteile und unsere Klischees, oder wie Siegmar Otto, Professor für Nachhaltige Entwicklung und Wandel an der Universität Hohenheim, in einem Vortrag sagte: „Bias in, Bias out.“

Nach dem Lesen des Artikels fragte ich mich: Wie gendert ChatGPT eigentlich im Deutschen? Ich habe einige Stichproben gemacht und nutze diesen Text einmal, um von ihnen zu berichten.

Im Gegensatz zum Englischen sind viele deutsche Berufsbezeichnungen entweder maskulin oder feminin (wie z.B. Lehrer oder Lehrerin). Es gibt jedoch auch Bezeichnungen, die für alle Geschlechter passen, z.B. Lehrkraft. Mich interessiert, welches Geschlecht ChatGPT mit den jeweiligen Berufen assoziiert.

Bekommen Erzieherinnen und Erzieher Arbeitszeugnisse mit unterschiedlichem Inhalt? Welches Pronomen wird die KI für eine Fachkraft wählen? Und macht es einen Unterschied für die Wahl der Pronomen, ob die Fachkraft kräftig, ehrgeizig oder gesprächig ist?

Die Ingenieurin wird im Arbeitszeugnis für ihre Loyalität, ihre Integrität und ihre engagierte Arbeitsweise gelobt, ebenso wie der Ingenieur. Die Texte sind, bis auf die Pronomen, deckungsgleich.

Als ich um ein Arbeitszeugnis für eine Pflegefachkraft bat, sagte die KI:

Die Pflegefachkraft ist in den Augen der KI weiblich. Sie kümmerte sich jedoch um (generisch maskuline?) Patienten und am Ende des Textes steht die Unterschrift des Vorgesetzten. Auch die fiktive Reinigungskraft heißt Frau [Name] und bekommt das Pronomen „sie“.

Die Fachkraft für Lagerlogistik blieb in den Augen der KI männlich, selbst als ich ihr das Adjektiv gesprächig zuwies:

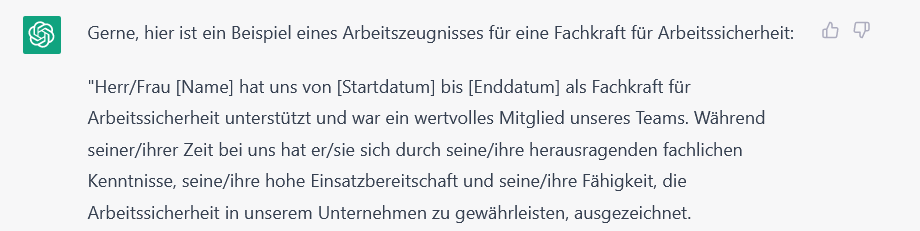

Anders gestaltet sich das bei einer Fachkraft für Arbeitssicherheit. Hier war sich die KI anscheinend nicht sicher, welches Geschlecht sie zuordnen soll und hat zwei Angebote gemacht:

Wie reagiert die KI auf weiblich oder männlich konnotierte Adjektive? Ändern sie etwas an den Pronomen? Mehrere Stichproben lieferten gemischte Ergebnisse. Als ich nach einem Zeugnis für eine kräftige Reinigungskraft fragte, antwortete ChatGPT mit einem Text für einen Mitarbeiter mit dem Pronomen „er“ und lobte seine „kräftige und gewissenhafte Arbeitsweise“. Bei einer Wiederholung der Frage schrieb die KI ein Zeugnis für Frau/ Herr [Name]. Die Pflegefachkraft blieb mit dem Attribut ehrgeizig weiblich. Als ich das Adjektiv stark hinzufügte, war die Pflegefachkraft im ersten Versuch männlich, im zweiten Versuch wurde das Zeugnis für Frau/Herr [Name] erstellt.

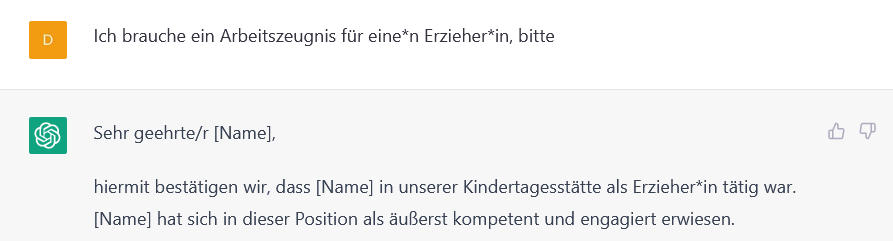

Vielleicht ist aufgefallen, dass in den vorherigen Beispielen

Am Ende des Texts steht jedoch der Name des Arbeitgebers/ Zeugnisausstellers (Maskulinum) und auch die Pronomen lauten „er“/„sie“ (ohne Sternchen). Die Anpassung an den Stil der Frage wird also nicht konsequent beibehalten.

Nach den ganzen Experimenten waren die KI und ich ganz schön durcheinander. Zwischendurch hatten wir über die Sinnhaftigkeit des Genderns und das Für und Wider des Sternchens diskutiert. Vieles ergab keinen Sinn. So ist das, wenn man mit einem Papagei konversiert. Aber es ist ein anpassungsfähiger Papagei. Meine letzte Anfrage war ein weiteres Arbeitszeugnis für eine Fachkraft für Lagerlogistik und ChatGPT antwortete: „Sehr gerne, hier ist ein Beispiel für ein Arbeitszeugnis für eine*n Fachkraft für Lagerlogistik“, und nutzte das Pronomen „sie“. Ich glaube, der Chatbot brauchte jetzt erstmal einen Kaffee.

Habt ihr ChatGPT schon ausprobiert? Wie hat die KI in euren Versuchen gegendert? Lasst es uns gerne in den Kommentaren wissen.